proxmox安装分区选择(proxmoxveZFS备份及恢复系统)

在pve中如果不小心误操作删除了系统分区的东西,或者升级调试有问题,有没有后悔药呢?有没有时间胶囊可以回到操作之前?

如果你的pve系统分区用的是zfs,是可以做到的,下面通过测试来模拟一下这个过程。

一、环境及准备这里是用pve来测试的,先看一下挂载:

root@pve:/# df -h

Filesystem Size Used Avail Use% Mounted on

udev 4.8G 0 4.8G 0% /dev

tmpfs 982M 9.0M 973M 1% /run

rpool/ROOT/pve-1 108G 901M 107G 1% /

tmpfs 4.8G 66M 4.8G 2% /dev/shm

tmpfs 5.0M 0 5.0M 0% /run/lock

tmpfs 4.8G 0 4.8G 0% /sys/fs/cgroup

rpool 107G 128K 107G 1% /rpool

rpool/ROOT 107G 128K 107G 1% /rpool/ROOT

rpool/data 109G 1.4G 107G 2% /rpool/data

/dev/fuse 30M 16K 30M 1% /etc/pve

//10.5.1.222/share 32G 12G 20G 37% /mnt/pve/omv-cifs

看一下zfs list 确定rpool/ROOT/pve-1是挂载到/目录下的,可以看到目前没有任何的快照

root@pve:/# zfs list

NAME USED AVAIL REFER MOUNTPOINT

rpool 7.35G 107G 96K /rpool

rpool/ROOT 902M 107G 96K /rpool/ROOT

rpool/ROOT/pve-1 902M 107G 901M /

rpool/data 6.46G 107G 1.31G /rpool/data

rpool/data/vm-100-disk-0 36.3M 107G 36.3M -

rpool/data/vm-101-disk-0 17.4M 107G 17.4M -

rpool/data/vm-101-disk-1 919M 107G 919M -

rpool/data/vm-101-disk-2 2.20G 107G 2.20G -

rpool/data/vm-102-disk-0 2.00G 107G 2.00G -

将rpool的属性修改一下,加上listsnapshots,可以用zpool get看一下属性有哪些:

root@pve:/# zpool get

missing property argument

usage:

get [-Hp] [-o "all" | field[,...]] <"all" | property[,...]> <pool> ...

the following properties are supported:

PROPERTY EDIT VALUES

allocated NO <size>

capacity NO <size>

dedupratio NO <1.00x or higher if deduped>

expandsize NO <size>

fragmentation NO <percent>

free NO <size>

freeing NO <size>

guid NO <guid>

health NO <state>

leaked NO <size>

size NO <size>

altroot YES <path>

ashift YES <ashift, 9-16, or 0=default>

autoexpand YES on | off

autoreplace YES on | off

bootfs YES <filesystem>

cachefile YES <file> | none

comment YES <comment-string>

dedupditto YES <threshold (min 100)>

delegation YES on | off

failmode YES wait | continue | panic

listsnapshots YES on | off

multihost YES on | off

readonly YES on | off

version YES <version>

feature@... YES disabled | enabled | active

The feature@ properties must be appended with a feature name.

See zpool-features(5).

我们需要加上listsnapshots=on

root@pve:/# zpool set listsnapshots=on rpool

给rpool/ROOT创建一个名字为20190416的快照

问:为什么只能rpool/ROOT创建快照?rpool/data没有?答:你也可以把rpool整个创建快照,整体恢复。我rpool/data下的虚拟机单独备份了,就不整体快照了,等恢复完rpool/ROOT后手工创建rpool/data,然后恢复单独的虚拟机备份。

root@pve:/# zfs snapshot -r rpool/ROOT@20190416回车没有报错基本就创建好了,zfs list看一下

root@pve:/# zfs list NAME USED AVAIL REFER MOUNTPOINT rpool 7.35G 107G 96K /rpool rpool/ROOT 902M 107G 96K /rpool/ROOT rpool/ROOT@20190416 0B - 96K - rpool/ROOT/pve-1 902M 107G 901M / rpool/ROOT/pve-1@20190416 1.48M - 900M - rpool/data 6.46G 107G 1.31G /rpool/data rpool/data/vm-100-disk-0 36.3M 107G 36.3M - rpool/data/vm-101-disk-0 17.4M 107G 17.4M - rpool/data/vm-101-disk-1 919M 107G 919M - rpool/data/vm-101-disk-2 2.20G 107G 2.20G - rpool/data/vm-102-disk-0 2.00G 107G 2.00G -看到已经创建好了

三、备份快照现在我们需要把快照存起来,可以挂一个物理硬盘或存到网络硬盘上,这里我们用已经挂载好的samba共享文件夹(cifs)

cifs

下面,来传送快照

~# zfs send -Rv rpool/ROOT@20190416 > /mnt/pve/omv-cifs/rpool/snaps/rpool.ROOT.2019041601执行后会提示信息,快照大小和进度,成功后就可以在共享文件夹中看到了

四、恢复快照

root@pve:/mnt/pve/omv-cifs/rpool/snaps# ls -alh total 0 drwxr-xr-x 2 root root 0 Apr 16 16:15 . drwxr-xr-x 2 root root 0 Apr 16 10:51 .. -rwxr-xr-x 1 root root 1.6G Apr 16 11:03 rpool.ROOT.2019041601恢复用了一台virtualbox虚拟机测试我这台虚拟机原来安装了一个pve系统,假设现在这个系统挂了,我现在把刚才备份的zfs快照恢复到这台虚拟机的pve中需要做一下准备工作:

在虚拟机用PVE的安装ISO启动在安装界面选第二个菜单(带debug mode那个),命令提示那里ctrl d继续,出现安装界面后点左下角的abort退出安装界面在退出安装界面后的命令行操作在虚拟机里把共享文件夹挂好 mount -t cifs -o username=用户名,password=密码 //ip/folder

挂载文件夹

查看硬盘分区

/dev/sda3是需要恢复的nfs分区 然后退出fdisk准备恢复

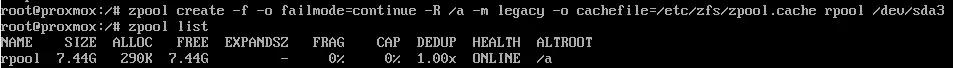

1. 查看测试zpool

zpool list

按提示加载zfs模块

2.重新创建根池

root@proxmox:/# zpool create rpool /dev/sda3

zpool create

从远程文件恢复

root@proxmox:/# cat /mnt/rpool/snaps/rpool.ROOT.2019041601 | zfs recv -Fdu rpool用-u选项表示zfs receive完成后不挂载恢复的文件

3. 验证根池数据集

image.png

可以看到数据和快照都恢复好了

4. 设置引导

- 如果这时不小心退出、关机、重启,可以用cd/ iso进来后zpool import rpool重新导入池

设置bootfs属性

root@proxmox:/# zpool set bootfs=rpool/ROOT/pve-1 rpool

- 这里如果硬盘是原硬盘,到这里重启就可以了。

- 注意:

- 如果无法加载zpool 会进到busybox界面,这里可以手工zpool import -N rpool成功后ctrl d或exit继续开机(有可能提示有多个rpool,可以zpool import看一下id,然后zpool impot id -N导入)(有可能提示pool may be in use on another system,用zpool import -fN rpool导入),进系统后,需要做两步:

- vi /etc/default/grub 把quiet改成rootdelay=4 quiet保存

- update-grub这两步没做会有这个提示:

- 如果不是原硬盘,是其他环境,就麻烦点了,看分割线下面

以下是针对不是原硬盘,是其他环境的情况:a. 修改zpool的挂载点,用chroot进去配置b. 重新配置grub

zfs set mountpoint=/mnt rpool/ROOT/pve-1 zfs mount rpool/ROOT/pve-1 mount -t proc /proc /mnt/proc mount --rbind /dev /mnt/dev mount --rbind /sys /mnt/sys #Enter the chroot chroot /mnt /bin/bash source /etc/profile

grub-install /dev/sda #这里的sda要根据实际情况,可以fdisk -l确认一下 update-grub2 grub-probe / update-initramfs -u -k all zfs set mountpoint=/ rpool/ROOT/pve-1 #退出chroot exit重启后就可以了

,

免责声明:本文仅代表文章作者的个人观点,与本站无关。其原创性、真实性以及文中陈述文字和内容未经本站证实,对本文以及其中全部或者部分内容文字的真实性、完整性和原创性本站不作任何保证或承诺,请读者仅作参考,并自行核实相关内容。文章投诉邮箱:anhduc.ph@yahoo.com