网络回溯分析与态势感知的区别(细粒度语义理解超越CLIP)

本文从博弈论的角度提出了一种细粒度语义对齐的视觉语言预训练模型(LOUPE),仅利用粗粒度的图片-文本对数据进行预训练,该模型可以直接零样本迁移到目标检测和视觉定位等需要物体层次细粒度语义理解的下游任务。

该模型为多模态预训练提供了一个新的思路,即从大规模粗粒度的图片-文本对数据中学习到细粒度的语义信息。

当前以CLIP为代表的大规模多模态预训练模型已经在多个下游任务中展现出了卓越的表现。然而,现有研究仅能提供粗粒度的图片和文本之间的整体对应关系,缺乏显式地对图片中所包含的特定视觉区域和文本中所包含的短语之间的细粒度语义对应关系进行推理的能力(如下图所示)。

在本文中,研究者从博弈交互的角度提出了一种细粒度语义对齐的视觉语言预训练模型(LOUPE)。此外,为了高效地计算博弈交互,研究者提出了一种基于不确定度估计的博弈交互学习模块。

实验表明细粒度语义对应关系建模能够有效提升预训练模型的性能,LOUPE在零样本图像分类、图像-文本检索等下游任务上实现了当前的最佳性能。此外,在不使用任何人工物体标注信息(Bounding-Box)和微调的情况下,LOUPE可以直接零样本迁移至目标检测和视觉定位任务。LOUPE为多模态预训练提供了一个新的思路,即从大规模粗粒度的图片-文本对中学习到细粒度的语义信息。

该研究已被 NeurIPS 2022 接收,论文标题为《Fine-Grained Semantically Aligned Vision-Language Pre-Training》:

论文预印本:https://arxiv.org/abs/2208.02515

代码和模型:https://github.com/YYJMJC/LOUPE

1 研究动机

近期,大规模视觉语言预训练模型(Large-scale vision-language pre-training models)在计算机视觉和多模态领域引起了广泛的关注。通过在大规模无标注的数据上进行自监督学习,所学习到的跨模态表征展现出了强大的迁移能力和泛化能力,在多个下游任务上取得了卓越的表现。

现有的视觉语言预训练模型主要通过计算输入图片和文本的全局表征之间的相似度和使用跨模态注意力机制来建模文本和图像的语义对应关系,缺乏显式地对图片中所包含的特定视觉区域和文本中所包含的短语之间的细粒度语义对应关系进行建模。

然而细粒度语义的理解对于很多下游跨模态推理任务来说是至关重要的,例如视觉定位和图像描述生成。因为现有的预训练数据仅能提供粗粒度的图像和文本之间的匹配关系,所以细粒度语义对齐的学习本质上是一个弱监督学习的问题。为了实现图像区域和文本短语之间细粒度语义对应关系的学习,以下两个问题需要解决:

1. 如何从输入图像中识别出包含语义信息的特定区域;

2. 如何建立图像语义区域和文本短语之间的对应关系;

为了解决上述问题,本文从博弈论的角度提出了一种细粒度语义对齐的视觉语言预训练模型(LOUPE)。研究者将通过Token-level博弈交互建模和Semantics-level博弈交互建模来分别解决以上两个问题,最终实现细粒度的语义对齐。

2 方法概览

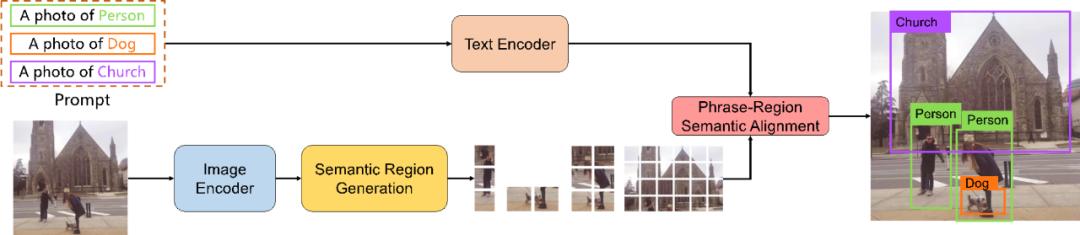

如下图所示,将文本和图像分别输入对应的编码器,LOUPE首先通过Semantic Region Generation模块定位图像中包含完整语义信息的视觉区域(Semantic Region),然后通过Phrase-Region Semantic Alignment模块来实现图像中语义区域和文本中的包含实体信息的短语之间的语义对齐。

具体地,视觉语义区域的定位和语义对齐的学习分别由本文提出的token-level博弈交互建模和semantics-level博弈交互建模来提供指导。

Token-level 博弈交互建模 (token-level Shapley interaction modeling)

研究者将输入的patch token视为博弈中的多个玩家并将图片和文本之间的相似度作为博弈的度量函数。

假设一些patch tokens所构成的区域对应了图像中的一个完整的视觉概念,那么它们将对图像和文本之间匹配关系的判断产生更大的作用,此时它们之间的博弈交互值将会更大(例如图像中女孩所对应的视觉区域与"A girl in a blue coat"能够比较好的对应,从而模型能基于此更好地判断图像和文本之间的匹配关系)。基于此,研究者将token-level博弈交互作为软标签来引导语义区域的生成。

Semantics-level 博弈交互建模 (semantics-level Shapley interaction modeling)

研究者将前一阶段所生成的所有语义区域和文本中的所有短语视为博弈中的多个玩家,并定义了一个基于语义区域和短语之间对应关系的细粒度相似度作为博弈的度量函数。假设一个语义区域和一个短语之间有明显的对应关系,那么它们之间的交互将更强,并对最终的博弈度量函数产生更大的贡献。通过度量每个视觉区域和短语对之间的博弈交互值,研究者将获得它们之间的对齐信息来指导预训练模型。

考虑到博弈交互的计算是一个NP难的问题,研究者提出了一种混合的博弈交互计算策略,采用一个基于不确定度估计的博弈交互学习方法和一个基于采样的博弈交互估计方法,在保障计算准确度的同时显著地提升了计算效率。

3 实验结果

研究者在图像-文本检索、图像分类、目标检测和视觉定位等多个下游任务上验证了方法的零样本(zero-shot)迁移能力。

在MSCOCO和Flickr30K数据集上的零样本图像-文本检索实验如下表所示,尽管所使用的预训练数据规模更小(CLIP 400M, ALIGN 1800M, FILIP 340M, LOUPE 240M),LOUPE在绝大多数指标上实现了SOTA的结果。

其中,在MSCOCO数据集以文搜图的Recall@1指标上,LOUPE取得了4.2%的显著性能提升。该项实验表明本研究所提出的细粒度语义对齐的视觉语言预训练框架具有更强大的迁移能力和泛化能力。

在11个数据集上的零样本图像分类实验如下表所示,LOUPE相较CLIP取得了3.1%的平均性能提升。其中在最大规模的ImageNet数据集上,LOUPE取得了0.8%的性能提升。此外值得注意的是,在Flowers102和Aircrafts这两个细粒度图像分类数据集上,LOUPE取得了显著的性能提升。该结果验证了LOUPE在细粒度语义理解上的优越性。

本研究所提出的方法不需要使用人工标注的目标检测框进行微调,可以直接零样本迁移至目标检测和视觉定位任务。

目标检测任务的完成方式如下图所示,LOUPE首先将输入图像进行编码并产生语义区域作为候选对象,然后通过手工定义的prompt模板将检测标签扩充为标签描述文本,最终通过计算候选语义区域和标签描述文本之间的相似度来完成目标检测。针对视觉定位,将标签描述文本替换为输入的指代描述文本即可。

研究者在COCO和PASCAL VOC数据集上对目标检测性能进行了测试,并在RefCOCO和RefCOCO 数据集上对视觉定位性能进行了测试。

测试结果如下表所示,LOUPE在没有使用任何标注数据进行微调的情况下,取得了具有竞争力的性能。该结果表明LOUPE通过本研究所提出的博弈交互学习到了细粒度的语义对应关系,从而能够直接零样本迁移至需要细粒度语义定位和理解能力的下游任务。

下图展示了部分LOUPE在目标检测和视觉定位任务上的结果。

考虑到人工物体标注成本高昂,并且现实世界中包含的物体类别难以通过人工标注的方式穷尽,本研究为开放域(零样本)目标检测提供了一种新的思路,即从海量的无标注图像文本对中学习到细粒度的语义对应关系,从而零样本迁移至目标检测任务。

值得注意的是,相较于人工标注的有限类别的目标检测数据集,网络上海量的无标注图像文本对中往往包含更加丰富和广泛的语义概念和视觉对象。研究者希望能够启发开放域目标检测的研究。

研究者通过下表所示的消融实验验分别验证了token-level博弈交互、semantics-level博弈交互、基于不确定度估计的博弈交互学习模块(UNSIL)的作用。通过比较最后两行方法的训练时间,研究者发现所提出的基于不确定度估计的博弈交互学习模块能够在保证性能的同时显著降低训练时间。

4 总结

本研究提出了一种新的视觉语言预训练框架,通过建模博弈交互的方式对视觉区域和文本短语之间的细粒度语义对应关系进行学习。为了提高博弈交互的计算效率,本研究提出了一种基于不确定度估计的博弈交互学习模块。实验结果表明本研究所提出的方法在多个下游任务上实现了SOTA的性能,并且能够零样本迁移至目标检测和视觉定位任务。

,免责声明:本文仅代表文章作者的个人观点,与本站无关。其原创性、真实性以及文中陈述文字和内容未经本站证实,对本文以及其中全部或者部分内容文字的真实性、完整性和原创性本站不作任何保证或承诺,请读者仅作参考,并自行核实相关内容。文章投诉邮箱:anhduc.ph@yahoo.com